Die Frage ist so alt wie Videokonferenzen selbst: Wer oder was kümmert sich darum, dass die Kameras die Sprechenden immer optimal ins Bild setzen? Im Eventbereich oder bei High End Meetings fällt die Antwort leicht: Hier sorgen erfahrende Kameraleute samt Videoregie für perfekte Bilder. Was aber machen wir Normalsterbliche in unseren Videocalls? Smarte Kameras im Meetingraum müssen her!

Wer soll überhaupt ins Bild?

Bei dieser Frage sind sich die Fachleute nicht immer einig.

Soll nur der gerade Sprechende zur Gegenstelle übertragen werden?

Alle Teilnehmer, um einen besseren Gesamteindruck zu bekommen? Dabei besteht aber die Gefahr, dass bei vielen Teilnehmern der eine Sprecher kaum mehr zu erkennen ist.

Vielleicht beides übertragen, einmal Speaker, einmal alle?

Oder gar ein IMAG-Setup für den Sprecher? Nun ja, hoffentlich nicht.

Trotzdem haben irgendwie alle recht.

Stetige Innovation im UC-Umfeld

In den letzten Jahren gab es eine stetige Weiterentwicklung bei diesem Thema. Interessanterweise herrscht eine fast verblüffender Synchronität zwischen den einzelnen Anbietern. Kaum hat Zoom ein neues Video-Features vorgestellt, folgt sogleich eine ähnliche Ankündigung von Microsoft. Trotzdem muss man ehrlicherweise festhalten, dass es Cisco Webex war und ist, die hier meist die Ersten mit solchen Innovationen sind. Über das norwegische „Video Valley“ wurde in diesem Blog schon mehrmals geschrieben. Wenn also von hoch innovativen Unternehmen wie Huddly oder Neat die Rede ist, so kommen erstaunlich viele der brillanten Köpfe ursprünglich aus genau jeder Ecke.

Welche Optionen gibt es aktuell?

Nachfolgend eine Übersicht der aktuell verfügbaren Varianten:

Mechanische Kameras

- Mechanische PTZ-Kameras mit manueller Steuerung

PTZ steht für Pan/Tilt/Zoom also Schwenk-Neige-Kamera mit Zoom-Optik. Bei dieser ältesten Form bedient ein menschlicher Operator eine oder mehrere Kameras. Man richtet die Kamera per Pan/Tilt auf das Ziel und wählt mit der Zoom Optik den geeigneten Bildausschnitt. Alternativ oder auch zusätzlich können mehrere vorher festgelegte Kamera-Presets schnell und unkompliziert angesprungen werden.

Das ist einfach, effektiv und liefert tolle Ergebnisse, ist aber eben manuell. - Mechanische PTZ-Kameras mit Videoanalyse

Wenn nun ein Computer anstatt eines Menschen die Videoanalyse macht, dann funktioniert es plötzlich ohne menschlichen Eingriff. Prinzipbedingt dauert es immer ein wenig, bis der neue Sprecher gefunden ist. Wenn die Kamera aber erstmals in die richtige Richtung zeigt, dann gibt es tolle Bilder. Im Video zum Poly EagleEye Director II sieht man noch eine weitere interessante Funktion: Neben dem Head-Shot wird ZUSÄTZLICH noch ein zweiter Videostrea mit dem „Gesamtbild“ geliefert. Dieser ist ohnehin schon vorhanden, weil eine zweite Kamera immer den gesamten Raum im Überlick hat, während die zweite per PTZ gesteuert wird.

Das funktioniert erstaunlich gut, obwohl in Wahrheit ziemlich getrickst wird. Die Kameras erkennen nämlich gar keine Menschen im Videobild (im Gegensatz zu aktuellen Lösungen, siehe unten!), sondern suchen nach (Mund)-Bewegungen in einem sonst statischen Bild! Hält sich der Sprecher folglich ein Blatt Papier vor den Mund, ist es oft ganz schnell vorbei mit der Smartness… 😉

Lösungen mit Digitalkameras

- Virtuelles PTZ mit Megapixel Kamera

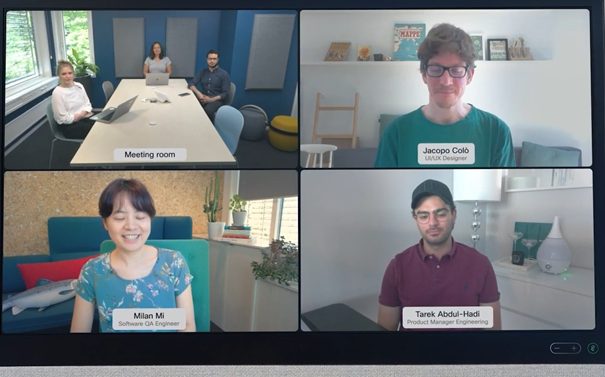

Wie schon im Blogpost zur Huddly IQ Kamera beschrieben, nutzt man hier die Tatsache, dass das vom Bildsensor aufgenommene Bild eine viel höhere Auflösung hat als benötigt wird. Man kann daher verlustfrei ins Bild hineinzoomen oder einen Ausschnitt wählen. Analog zum mechanischen PTZ gibt es auch hier manuelle oder videobasierte, automatische Lösungen. Diese nennen sich je nach Hersteller People Focus, Genius Framing o.ä. und sollen entweder alle Anwesenden oder nur den Sprecher optimal einfangen. Ein dynamisches Tracking verfolgt den Sprecher auch dann, wenn er z.B. durch den Raum geht. Grundlage dafür ist das Erkennen von Menschen im Videobild und das ist noch gar nicht lange technisch aus wirklich lösbar. (im Vergleich zu nicht ganz so smarten Lösungen wie unter 2. beschrieben) - Die nächste Evolutionsstufe löst ein weiteres häufiges Problem. Nimmt eine Weitwinkel-Kamera einen Meetingraum mit mehreren Teilnehmern auf, so sind die einzelnen Köpfe oft kaum mehr zu erkennen. Social Distancing verstärkt den Effekt nochmals, wo vor lauter Raum die Gesichter kaum mehr zu erkennen sind. (siehe Bild 1 unten)

Lösungen wie zum Beispiel Smart Gallery von Zoom oder People Focus von Webex stanzen daher aus dem großen Videobild jene Bereiche aus, in denen Menschenköpfe zu erkennen sind und senden diese als unabhängige Videostreams zur Gegenstelle. (siehe Bild 2 unten)

Wirklich smart wird es, wenn jeder der einzelnen Streams wiederum per People Focus seinem Gesicht folgt.

Audiobasierte Kamerasteuerung

Die Entwicklung in Sachen smarte Kameras im Meetingraum ist damit aber noch lange nicht am Ende. Mit dem Aufkommen von Beamtracking/Beamforming Mikrofon-Arrays wird anstatt des Videobildes verstärkt die Audio-Information zur Steuerung der Kameras verwendet. Diese Mic-Arrays sind in der Lage Ihre Richtcharakteristik dynamisch zu ändern. Sie „zeigen“ also immer zum Sprecher. Wenn nun das Mikrofon permanent die Koordinaten seiner aktuellen Ausrichtung an ein Steuersystem übermittelt, das Mikrofon also die Information liefert, WO im Raum gerade jemand spricht, so ist es keine große Hexerei mehr, eine oder mehrere Kameras genau dorthin zu steuern.

Und wie geht es weiter?

Ohne diverse NDAs zu brechen, darf ich an dieser Stelle nicht allzu viel über vielleicht schon sehr bald verfügbare weitere News verraten. Ein kleiner Hinweis darf aber sein:

Bisher haben praktisch alle Anbieter versucht, möglichst viele Informationen aus EINEM Kamerabild zu entnehmen. Was aber, wenn es mehrere Kameras im Raum gibt bzw. geben muss? Wenn Kamera 2 einen besseren Blick auf User X hat als Kamera 1? Wenn User Y aus dem Schwenkbereich von Kamera 1 geht und sich direkt vor das Whiteboard stellt, auf das schon Kamera 3 gerichtet ist?

Na, alles klar? 😉

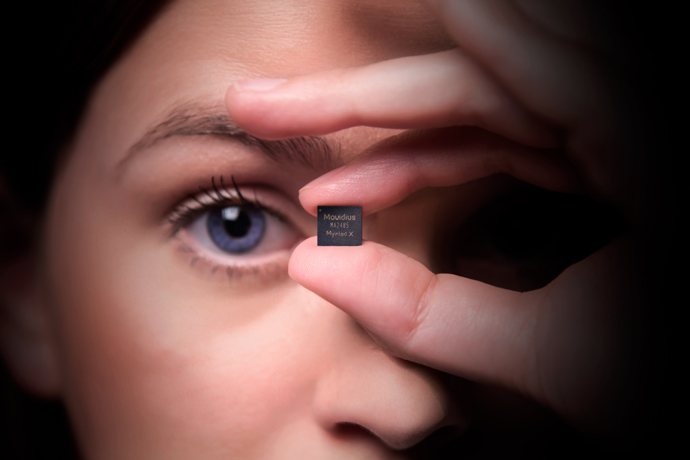

Praktisch alle oben angeführten Beispiele wären ohne moderne Videoanalyse mittels AI und neuronalen Netzwerken nicht möglich. Für uns AV-Leute sind es smarte Kameras im Meetingraum, aber die Technik dahinter ist mehr als nur faszinierend. Ich entlasse Sie mit einem Video über den Movidius Myriad X Chip von Intel. Dieser Chip ist gerade einmal 14 x 14 x 1mm groß und passt somit in jede Webcam. Wenn das kein Versprechen für die Zukunft ist…..